Mamba虽然具有很好的潜力,但仍处于发展的初期阶段。

近年来,深度学习架构繁多,而Transformer无疑是最成功的架构之一,已在多个应用领域确立了主导地位。其成功的关键在于引入的注意力机制,使得基于Transformer的模型能够关注输入序列的相关部分,从而实现更有效的上下文理解。然而,注意力机制的不足之处在于计算开销巨大,并且随着输入规模的增加,计算复杂度呈二次增长,这使得处理超长文本变得困难。

幸运的是,最近出现了一种颇具潜力的新架构:结构化状态空间序列模型(SSM)。该架构高效捕捉序列数据中的复杂依赖关系,成为Transformer的一大竞争者。这类模型的设计灵感来自经典的状态空间模型,可以看作是循环神经网络和卷积神经网络的结合体。它们能够通过循环或卷积运算进行高效计算,使得计算开销随序列长度线性或近似线性变化,从而大幅降低了计算成本。

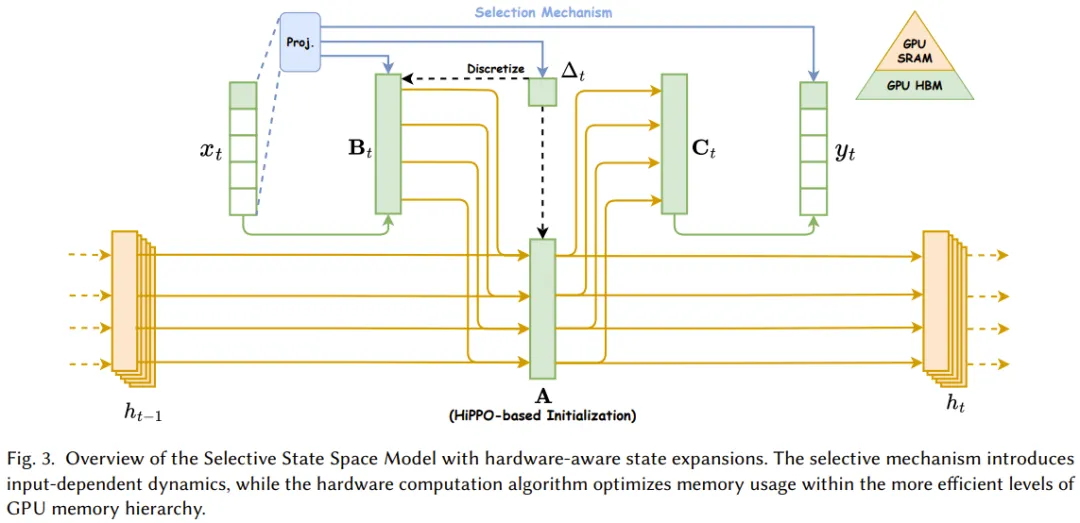

具体而言,SSM的一个成功变体Mamba的建模能力已可与Transformer媲美,并且保持了与序列长度的线性可扩展性。Mamba首先引入了一种简单却有效的选择机制,通过对SSM进行重新参数化,根据输入来筛选出不相关的信息,同时保留必要的相关数据。此外,Mamba还采用了一种硬件感知算法,通过扫描(scan)而非卷积的方式进行循环计算,使得在A100 GPU上的计算速度提高了三倍。

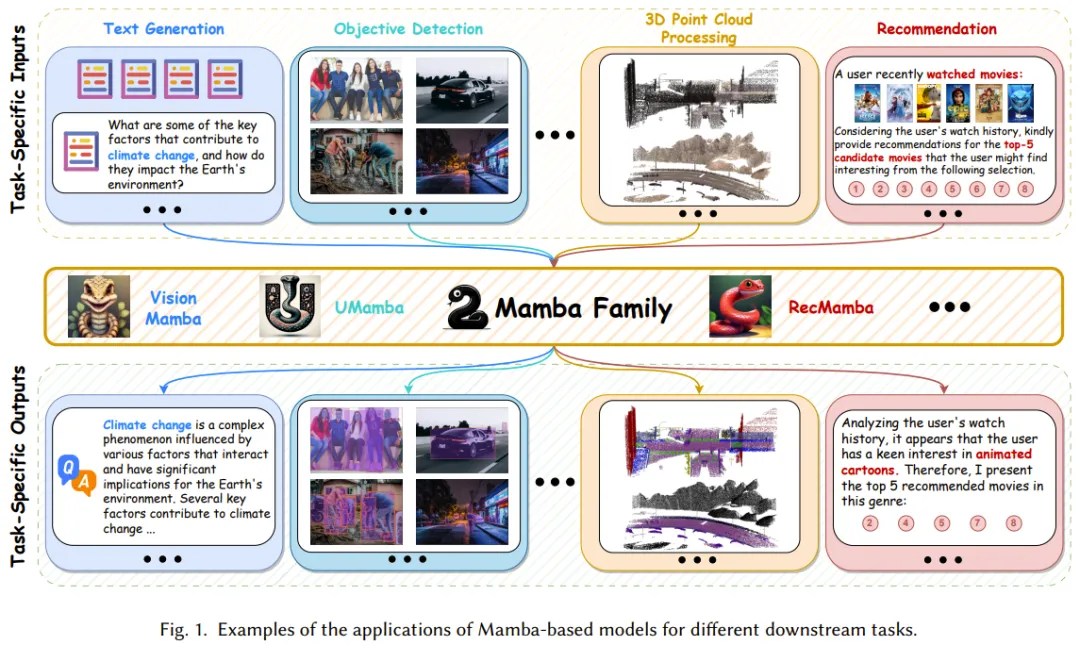

凭借强大的建模能力以及近乎线性的可扩展性,Mamba已经崛起成为一种基础模型,预示着它将在计算机视觉、自然语言处理、医疗等多个研究和应用领域产生深远影响。

研究和应用Mamba的文献迅速增长,涌现出大量的综述报告,较为全面的文献必将提供极大的帮助。近期,香港理工大学的研究团队在arXiv上发布了他们的贡献。

- 论文标题:A Survey of Mamba

- 论文地址:https://arxiv.org/pdf/2408.01129

这份综述从多个角度总结了Mamba的工作机制,既适合初学者理解Mamba基础知识,也为经验丰富的实践者提供最新进展。Mamba作为一个热门研究方向,目前已有多支团队尝试撰写相关综述,除了本文介绍的,还有其他研究聚焦于状态空间模型或视觉Mamba的综述,具体可参考以下论文:

- Mamba-360: Survey of state space models as transformer alternative for long sequence modelling: Methods, applications, and challenges. arXiv:2404.16112

- State space model for new-generation network alternative to transformers: A survey. arXiv:2404.09516

- Vision Mamba: A Comprehensive Survey and Taxonomy. arXiv:2405.04404

- A survey on vision mamba: Models, applications and challenges. arXiv:2404.18861

- A survey on visual mamba. arXiv:2404.15956

必备知识

Mamba结合了循环神经网络(RNN)的循环框架、Transformer的并行计算与注意力机制,以及状态空间模型(SSM)的线性特性。因此,全面理解Mamba需要先掌握这三种架构。

循环神经网络(RNN)

循环神经网络(RNN)具备记忆能力,适合处理序列数据。在每个离散的时间步骤k,标准的RNN在处理一个向量时同时考虑前一时间步骤的隐藏状态,并更新隐藏状态以输出新的向量。这个隐藏状态就成为RNN的记忆,能够保留之前信息,使得RNN能够有效捕获时间模式。

Transformer

Transformer的自注意力机制帮助捕获输入中的全局依赖,通过计算每个位置相对于其他位置的重要性,分配权重。具体而言,原始输入经过线性变换转化为查询Q、键K和值V向量,然后计算归一化的注意力分数和权重。利用多头注意力机制,模型可以从多个视角理解输入序列,实现多种关系的捕获。

状态空间模型(SSM)

状态空间模型(SSM)是用以描述系统随时间演变的动态行为的传统数学框架。SSM通过一组名为“状态”的隐藏变量,能够有效捕捉时间数据中的依赖关系。与RNN不同,SSM是一种线性模型,其通过状态方程和观察方程建模当前时间t时输入x与输出y之间的关系。

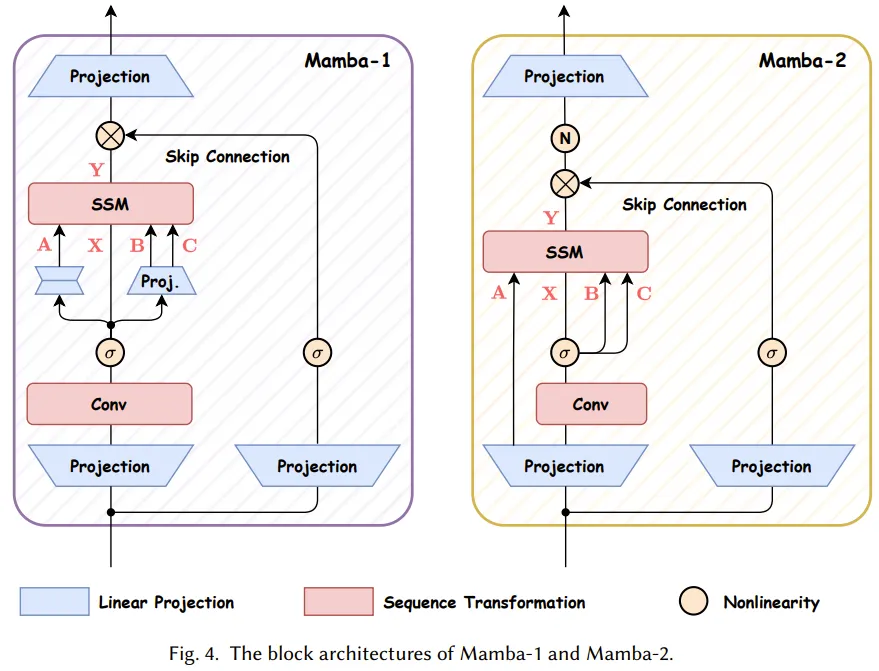

Mamba的技术进步与创新

为了解决传统SSM的不足,Albert Gu和Tri Dao提出了Mamba作为通用序列基础模型的主干网络。随后,他们又提出了Mamba-2,构建了结构化状态空间对偶(SSD),这一框架将SSM和各种形式的注意力机制结合在一起,使原本为Transformer开发的算法和系统优化技术能够有效迁移到SSM上。

Mamba-1:硬件感知算法的选择式状态空间模型

Mamba-1基于结构化状态空间模型引入了三项创新:基于高阶多项式投影算子(HiPPO)的内存初始化、选择机制和硬件感知型计算。这些技术旨在提升SSM的长程线性时间序列建模能力。

Mamba-2:状态空间对偶

Mamba-2引入了结构化状态空间对偶(SSD)框架,使得SSM能够受益于Transformer领域的多种技术,包括参数高效微调、灾难性遗忘缓解和模型量化。通过半可分离的矩阵变换,Mamba-2在训练速度和性能上均优于前一代Mamba-1。

Mamba模型的未来发展

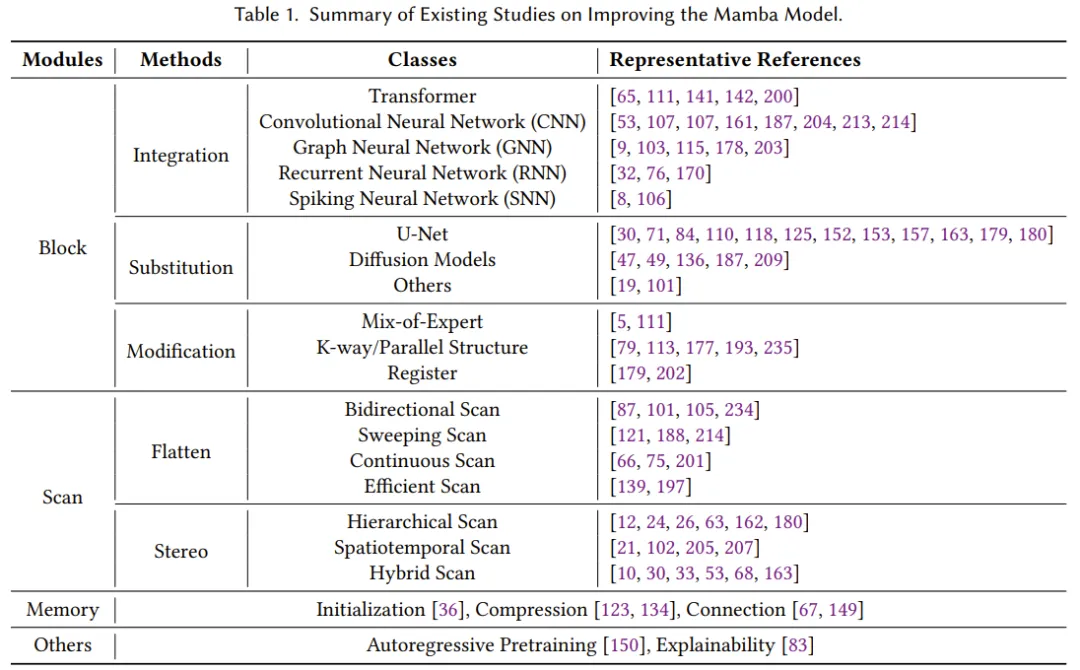

尽管Mamba在自然语言处理等任务中表现出色,但仍面临诸多挑战,如记忆丢失、泛化能力不足等。研究社区正在努力提出改进方案,主要集中在区块设计、扫描模式和记忆管理上。

结论

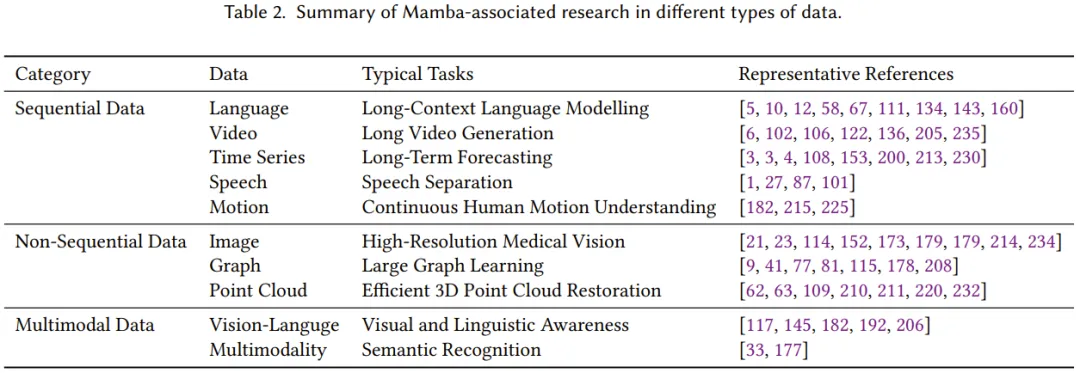

Mamba架构作为选择式状态空间模型的扩展,展现了处理文本、时间序列、语音等序列数据的巨大潜力。近期研究的拓展性应用也显示出Mamba在图像、图谱等领域的适用性,这预示着Mamba在多模态学习方面可能成为Transformer的有力竞争者。

持续的挑战与机遇

尽管Mamba在多个领域已有所成就,但总体而言,研究仍处于起步阶段,面临着不少挑战。这些挑战同时也为研究者提供了机遇:如何在Mamba模型的基础上进行进一步开发和改进,以实现更高的效率和可靠性。