什么是CUDA

CUDA(Compute Unified Device Architecture)是英伟达推出的基于其GPU的通用高性能计算平台和编程模型。通过CUDA,开发者能够有效利用英伟达GPU的强大计算能力,以加速各种计算任务。

软件生态的基石

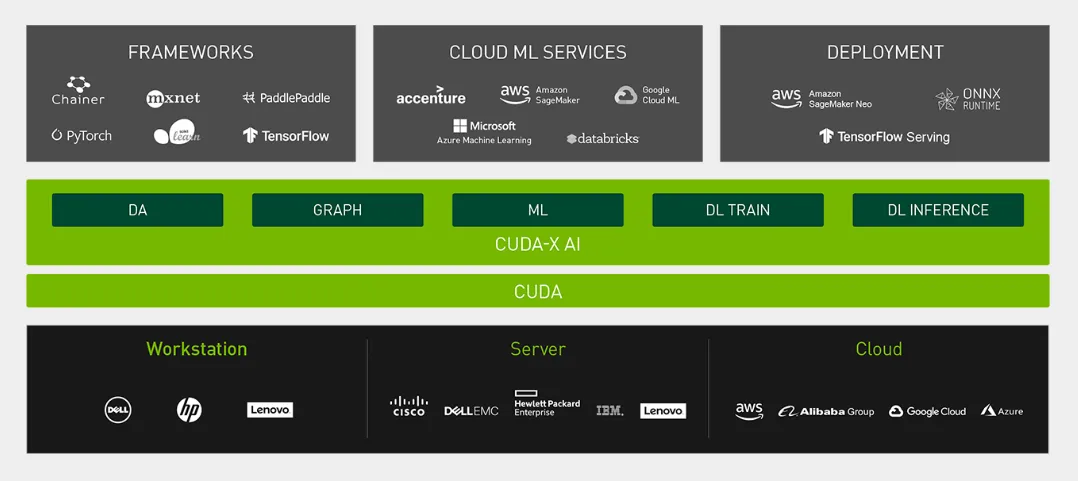

CUDA构成了英伟达软件生态的基础,许多前沿技术均基于CUDA构建。例如,TensorRT、Triton和Deepstream等技术解决方案都是在CUDA平台上开发的,展现了CUDA在促进软件创新方面的强大能力。

软硬件的桥梁

尽管英伟达的硬件性能卓越,要充分发挥其潜力,必需有相应的软件支持。CUDA恰好充当了这种桥梁,提供强大的接口,使得开发者能够充分利用GPU硬件进行高性能计算的加速。可以将CUDA比作一位熟练的驾驶员,确保硬件性能得到充分发挥。

深度学习框架的加速器

CUDA在构建英伟达自身软件生态中发挥了关键作用,同时也推动了第三方软件生态的发展。在深度学习领域,CUDA为多个深度学习框架提供了强大的加速支持。例如,在流行框架如Pytorch和TensorFlow中,CUDA加速功能已成为标准配置。开发者只需简单的设置,便可利用GPU进行高效的训练和推理任务,从而显著提升计算性能。

CPU与GPU的异构计算

CPU

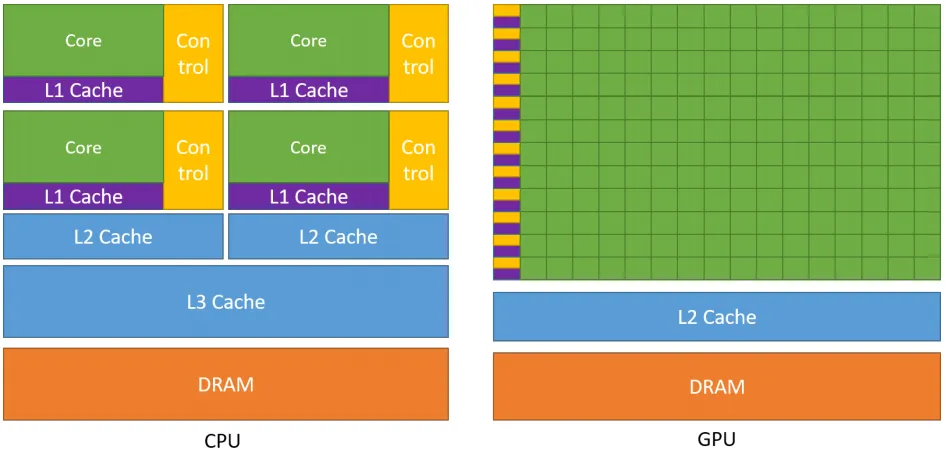

中央处理器(CPU)是计算机系统的运算和控制核心,负责信息处理和程序执行。尽管运算核心较少,但CPU能够执行复杂的逻辑运算,适用于控制密集型任务。CPU更擅长数据缓存和流程控制(即少量的复杂计算)。

GPU

图形处理器(GPU)最初主要用于图形处理,而在深度学习蓬勃发展的今天,GPU的高效并行计算能力得到了广泛应用。GPU拥有更多运算核心,特别适合数据并行的计算密集型任务,如大型矩阵运算(即大量的简单运算)。

| 特点 | CPU | GPU |

|---|---|---|

| 运算核心 | 运算核心少,适合复杂的逻辑运算,适合控制密集型任务 | 运算核心数多,适合数据并行的计算密集型任务,如大型矩阵运算 |

| 线程 | 线程是重量级的,上下文切换开销大 | 多核心,因此线程是轻量级的 |

一个典型的CPU拥有少数几个快速的计算核心,而一个典型的GPU则拥有数百到数千个较慢的计算核心。CPU的设计侧重于数据缓存和复杂的流程控制,而GPU则将大量晶体管用于算术逻辑单元,以实现并行处理能力。因此,GPU通过众多计算核心的集群来实现其较高的计算性能。

使用CUDA编程,开发者可以精确指定数据如何分配到GPU的各个核心上,并控制这些核心如何协同工作以解决问题。

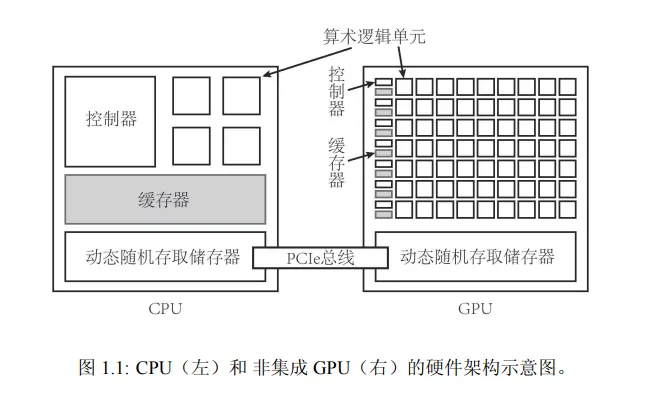

GPU是作为CPU的协处理器工作,由CPU进行调度,CPU与GPU组成异构计算架构。在这种架构中,CPU被称为主机(host),而GPU被称为设备(device)。主机和设备之间的内存访问通常通过PCIe总线连接。

计算生态

开发工具链

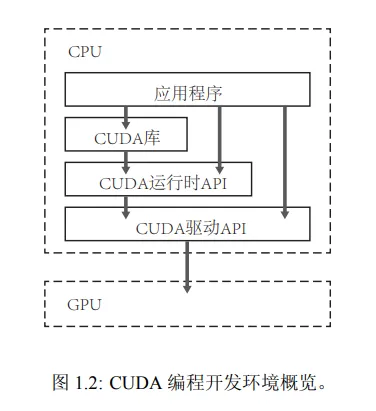

① NVIDIA驱动

显卡驱动是连接操作系统与显卡硬件之间的桥梁,确保显卡正常工作并发挥最佳性能。它包含硬件设备的信息,使得操作系统能够识别并与显卡硬件进行通信,对启用显卡的全部功能、性能优化、应用程序兼容性等均至关重要。

② CUDA Toolkit

CUDA Toolkit是由NVIDIA开发的一个软件开发工具包,提供了一组API和工具,使开发人员可以利用GPU的并行计算能力加速计算密集型应用程序。它包含CUDA编译器(NVCC)、运行时库、驱动程序等组件,共同为开发者提供支持。

③ CUDA API

CUDA API是CUDA编程的接口集合,允许开发者使用CUDA进行高性能计算。它包括CUDA Runtime API和CUDA Driver API,提供管理设备、内存和执行等功能的函数,开发者可以通过这些接口编写CUDA程序,以利用GPU的并行计算能力。

④ NVCC

NVCC是CUDA的编译器,隶属于CUDA Toolkit,位于运行时层。它作为编译器驱动程序,简化了C++或PTX代码的编译过程。开发者在编写CUDA程序时,需要使用NVCC来编译包含CUDA核心语言扩展的源文件。

NVIDIA驱动为显卡正常工作提供基础,而CUDA Toolkit则是利用GPU进行高性能计算的软件开发工具包,CUDA API是编程接口,NVCC则是将CUDA程序编译为可在GPU上执行的代码的编译器。

应用框架与库支持

CUDA广泛支持科学计算、工程、数据分析、人工智能等领域的应用框架和库。在深度学习领域,TensorFlow、PyTorch、CUDA深度神经网络库(cuDNN)等工具均与CUDA深度整合,使开发者可以轻松利用GPU加速神经网络的训练和推理过程。

深度学习框架

-

TensorFlow:由Google开发的开源机器学习框架,支持分布式计算,并高效利用GPU进行数值计算,底层使用了CUDA和cuDNN等NVIDIA库以加速深度学习模型。

-

PyTorch:Facebook人工智能研究院(FAIR)开发的深度学习框架,支持CUDA,并提供丰富的API以方便开发者使用GPU进行深度学习模型的训练和推理。

CUDA库

-

cuBLAS:用于线性代数运算的库,如矩阵乘法和前缀求和,广泛应用于科学与工程计算。

-

cuDNN:NVIDIA CUDA深度神经网络库,专为深度学习设计,提供了一系列高效的深度学习算法实现。

-

cuSPARSE:针对稀疏矩阵的线性代数库。

-

cuFFT:快速傅里叶变换库,用于高效执行FFT(快速傅里叶变换)操作。

-

cuRAND:随机数生成库,允许开发者在GPU上生成随机数。

这些库为开发者提供了丰富的计算资源,使他们能够更高效地开发GPU加速的应用程序。

CUDA编程语言

CUDA支持多种编程语言,包括C、C++、Fortran、Python和MATLAB。