Serge核心特性解析 基于llama.cpp框架构建的开源聊天界面,支持本地化运行各类大型语言模型(LLM)。最大特色在于完全摆脱API密钥依赖,实现真正意义上的自主托管,确保数据隐私与运行独立性。

详细部署流程

Docker Compose配置方案

services:

serge:

image: ghcr.io/serge-chat/serge:latest

container_name: serge

restart: unless-stopped

ports:

- 8008:8008

volumes:

- /vol1/1000/docker/serge/weights:/usr/src/app/weights

- /vol1/1000/docker/serge/datadb:/data/db关键参数说明

/usr/src/app/weights:模型权重文件存储目录/data/db:会话数据与运行日志持久化路径 (建议查阅官方文档获取进阶配置参数)

操作使用指南

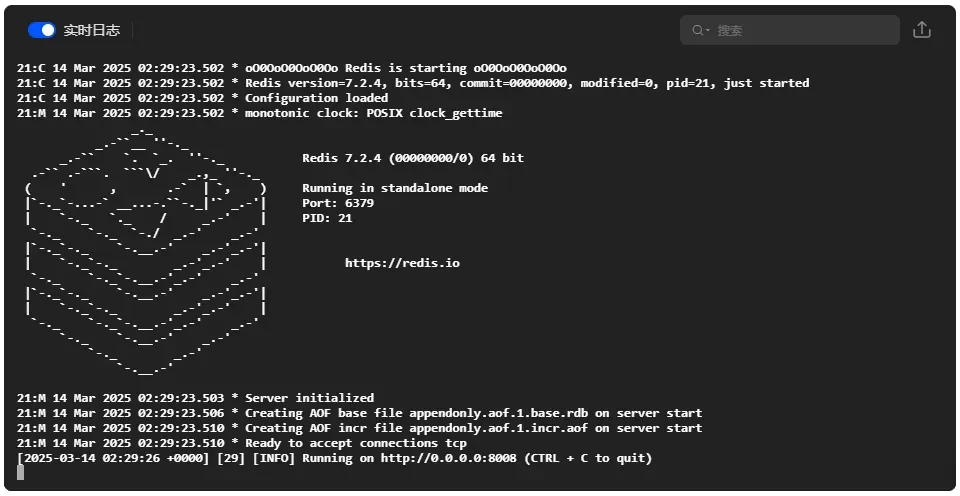

初始化注意事项 首次启动将自动下载依赖文件,可通过容器日志实时监测进度:

docker logs -f serge

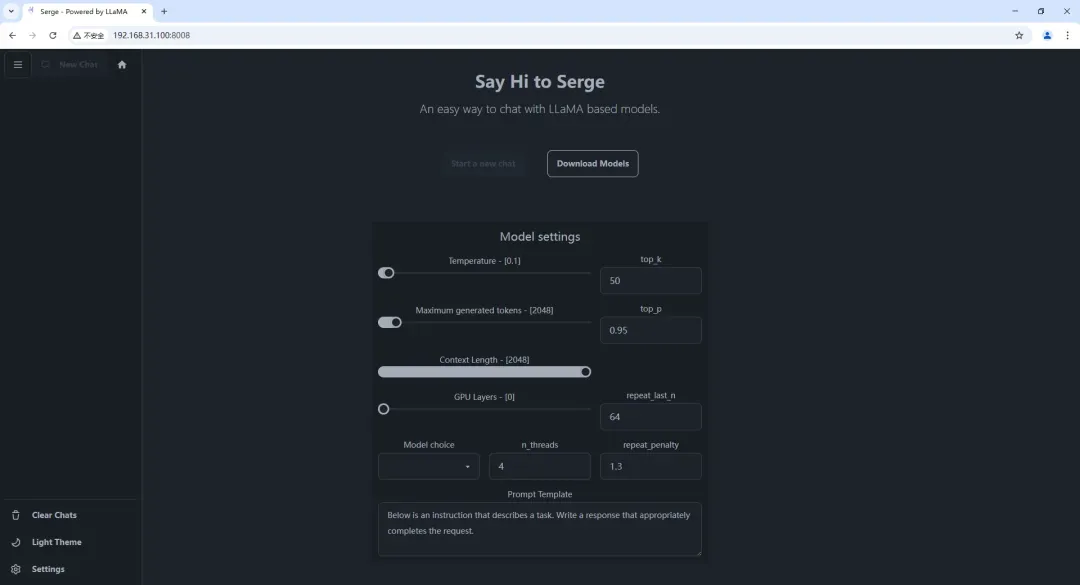

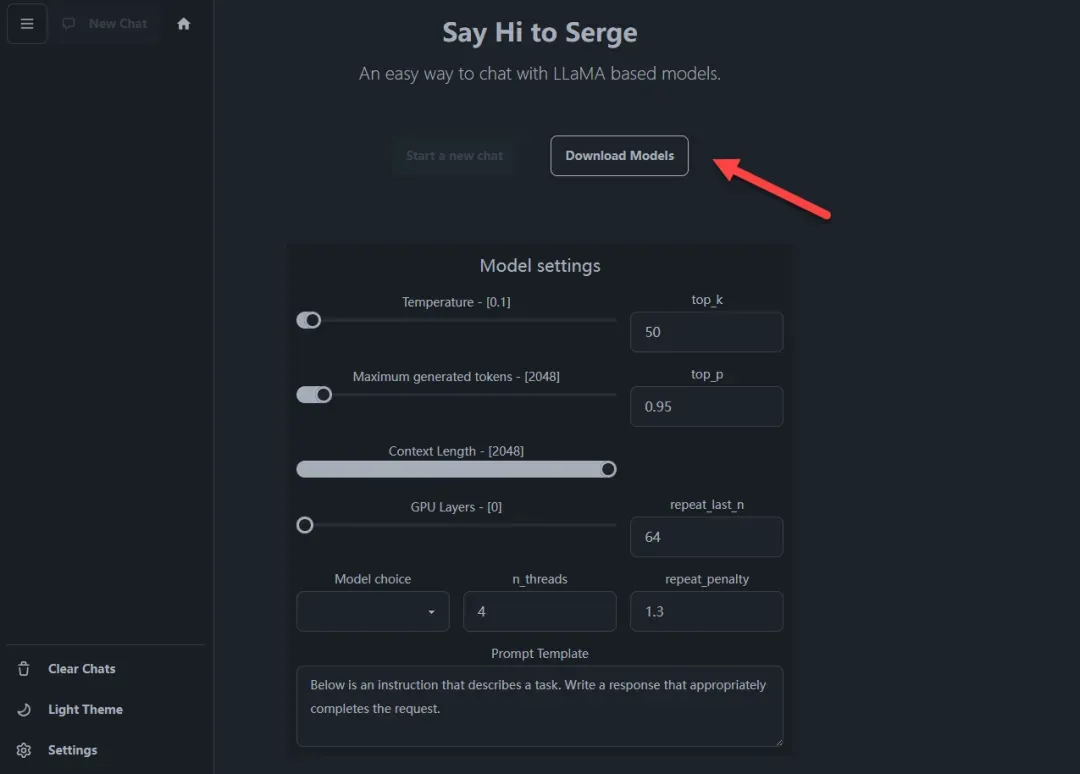

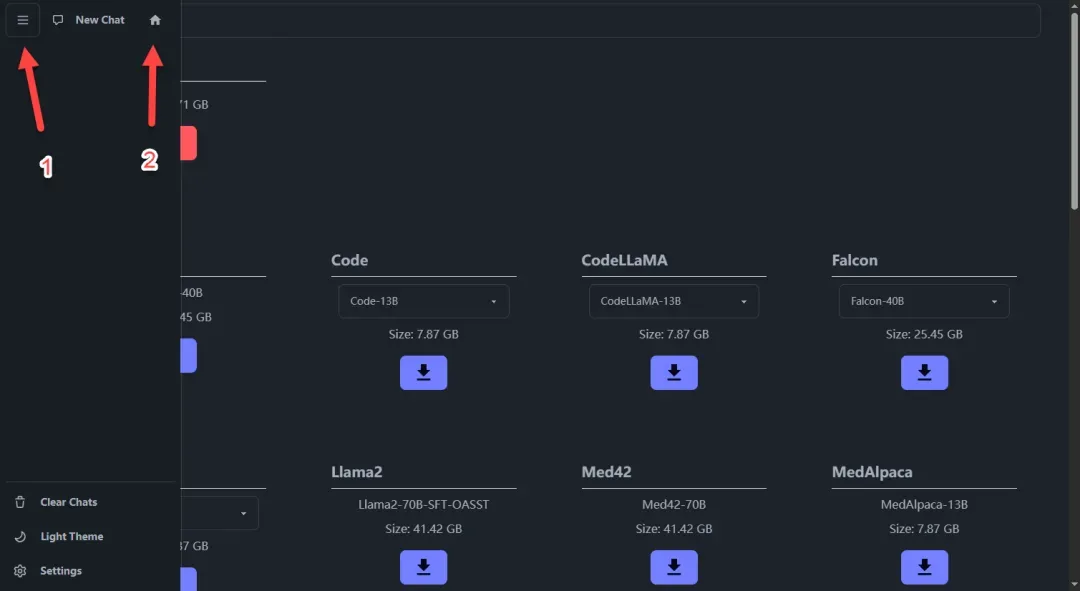

访问控制台 浏览器输入 http://NAS_IP:8008 进入主界面

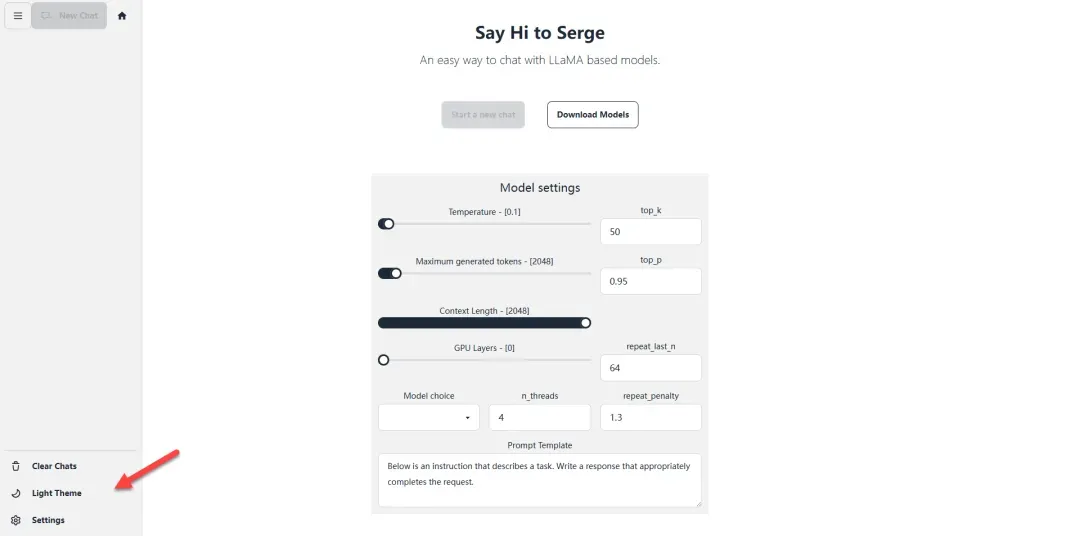

界面个性化设置 支持亮色/暗色主题切换

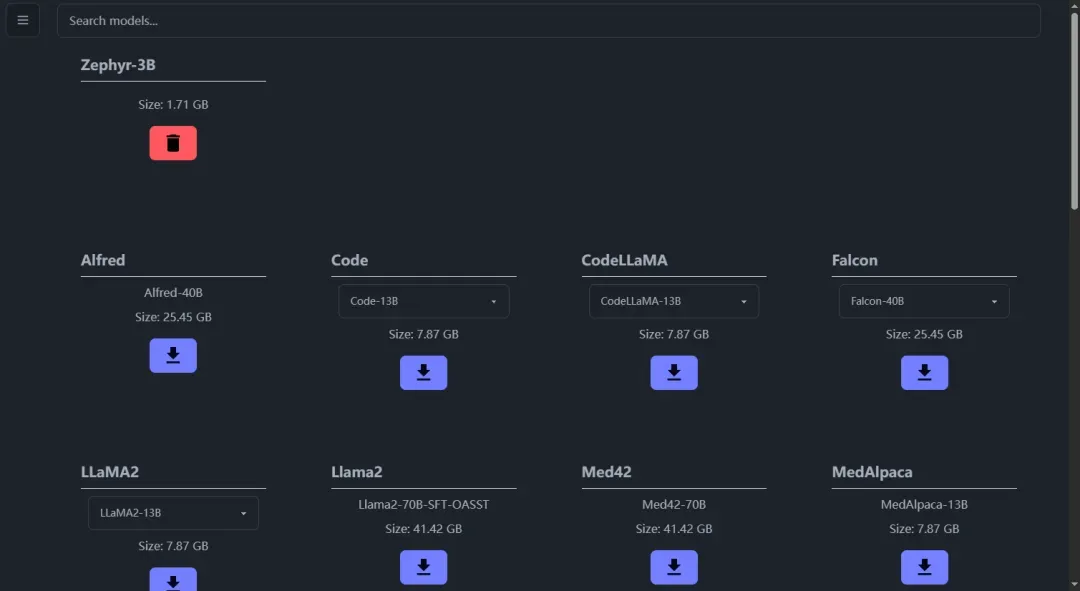

模型管理操作

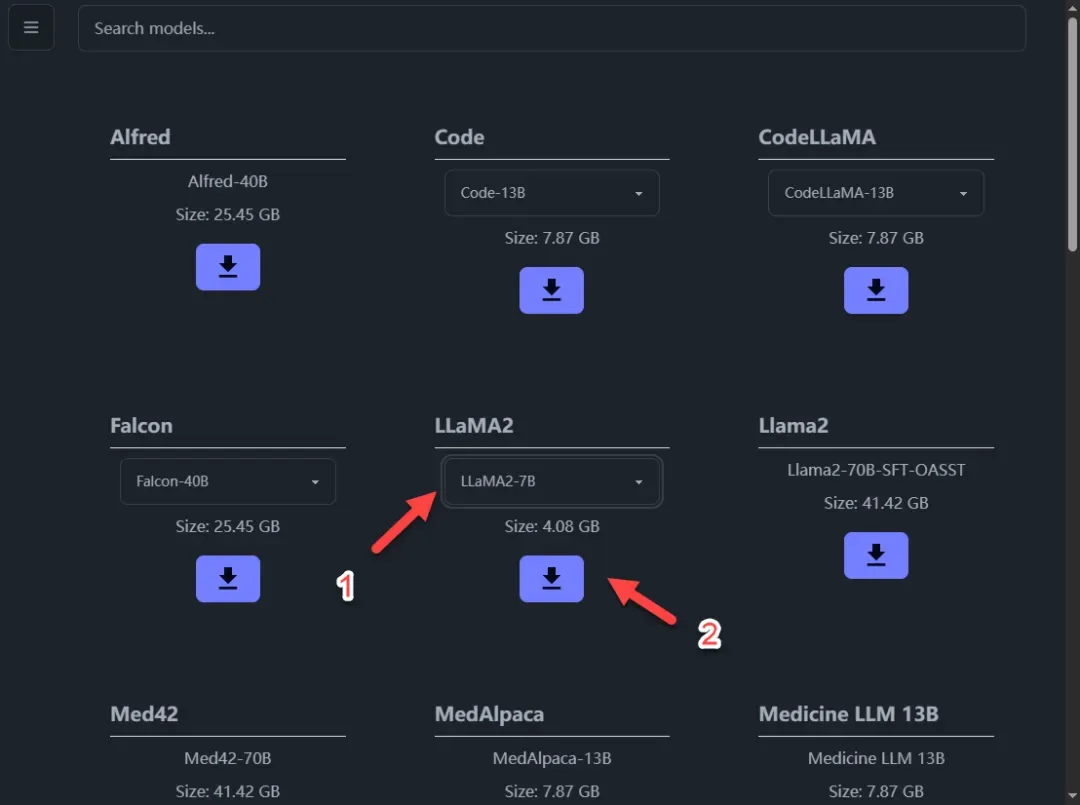

进入模型下载中心

查看可用模型清单(持续更新中)

硬件资源参考

实践建议:13B以上模型响应延迟显著增加,影响交互体验

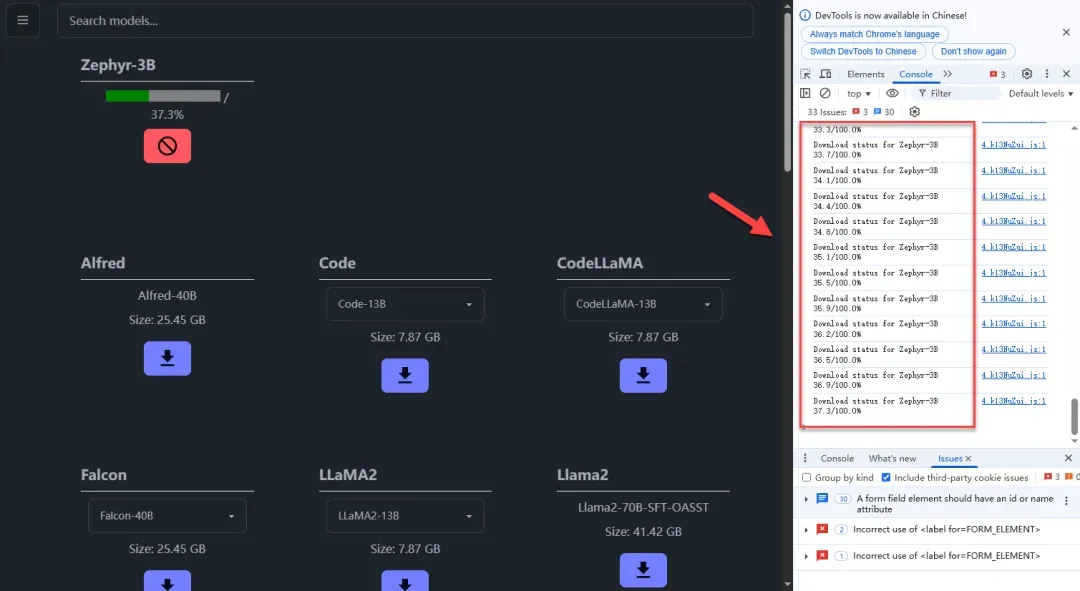

下载异常处理

点击无响应:通常为网络连接问题

中断重连:支持断点续传

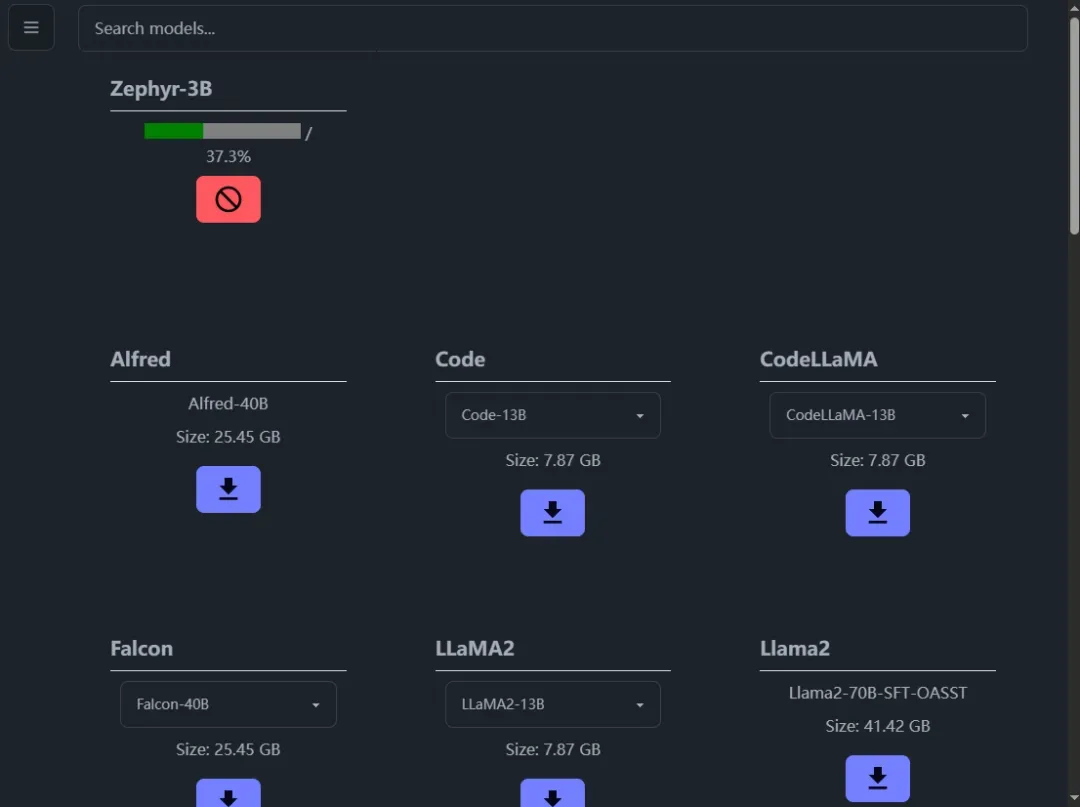

完成验证 下载进度条满格即表示就绪(红色按钮为删除功能)

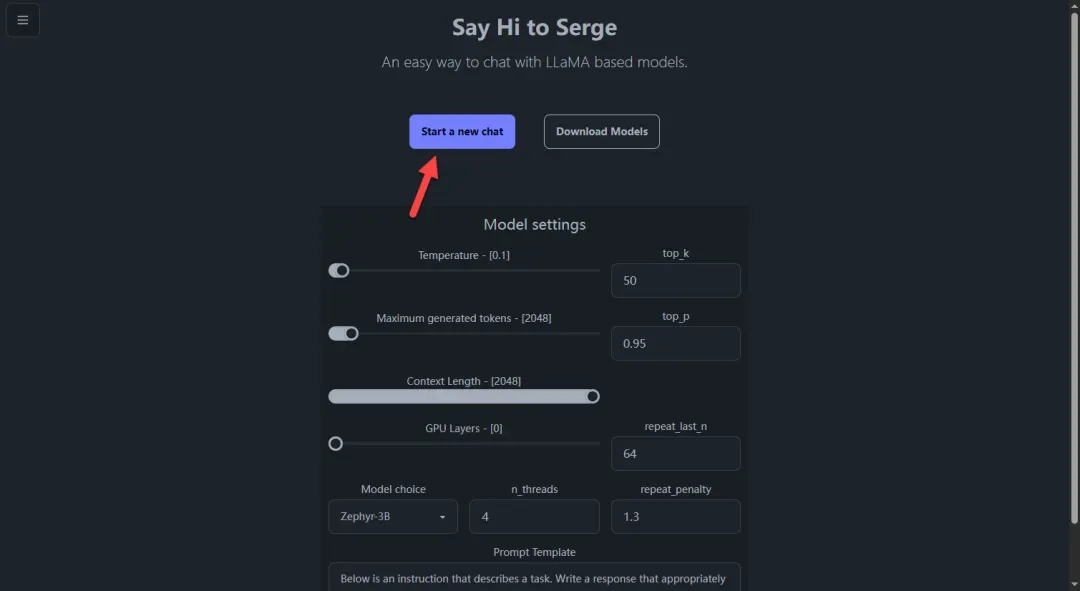

开始对话

返回主界面选择模型

保持默认参数启动聊天

实时交互演示

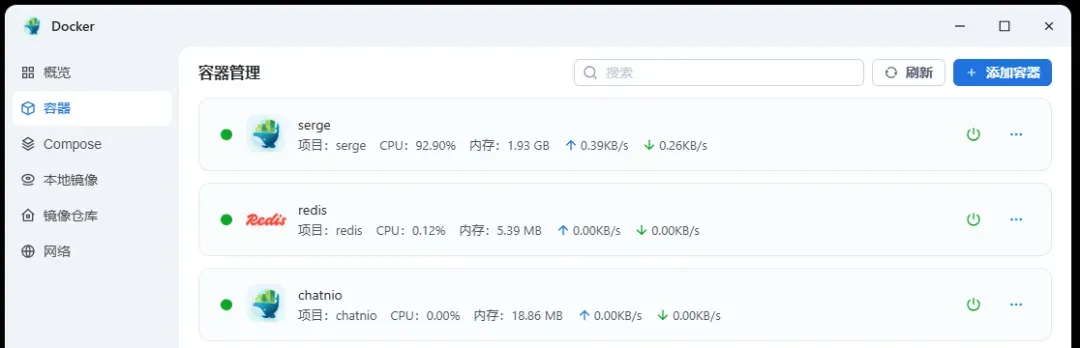

资源监控 虚拟机测试环境资源占用示例(1.5B小模型):

CPU利用率:接近100%

内存占用:维持在较低水平

综合评估报告

适用场景分析

生产力工具:API调用方案更高效

模型丰富度:不及Ollama等平台

核心优势:开箱即用的集成框架

网络要求说明 模型下载需稳定网络环境,中断风险显著高于早期版本

三维评分体系